Pulire i dati con Python e Panda

I dati sono come gli elementi costitutivi del processo decisionale odierno. Ma immagina di avere un gruppo di blocchi di diverse forme e dimensioni di questa collezione; è difficile costruire qualcosa di significativo. È qui che entra in gioco la pulizia dei dati.

Questa guida esplora come pulire i dati utilizzando il framework Python che è Panda per un migliore processo decisionale. Anche la pulizia dei dati è essenziale, considerando che stiamo lavorando con un elenco di record di vendite per un negozio. Potremmo notare alcuni numeri mancanti, date strane ed elementi ripetuti senza motivo nell'elenco. Se effettuiamo calcoli o registrazioni in base a queste informazioni, questi problemi possono confondere i nostri calcoli e previsioni. La pulizia dei dati aiuta a risolvere questi problemi, garantendo che i nostri dati siano accurati e pronti per l'uso.

La pulizia dei dati include la gestione dei dati mancanti e cosa fare quando mancano alcuni dati, la rimozione dei duplicati, l'eliminazione delle cose copiate, la correzione dei tipi di dati, l'assicurazione che tutto sia nel formato corretto e la gestione dei valori anomali o la gestione dei numeri che non si adattano. Questi errori fanno sembrare i dati uguali e standardizzano il modo in cui appaiono.

Per iniziare, assicurati prima di avere installato Python e Panda. Possiamo farlo digitando i comandi nel terminale del nostro computer o nel prompt dei comandi. Per implementare i codici menzionati in questa guida, possiamo utilizzare l'IDE Python Pycharm installato sul nostro sistema o la piattaforma Python online che è 'Google Colab' e installare i comandi 'pip' per installare le librerie importanti.

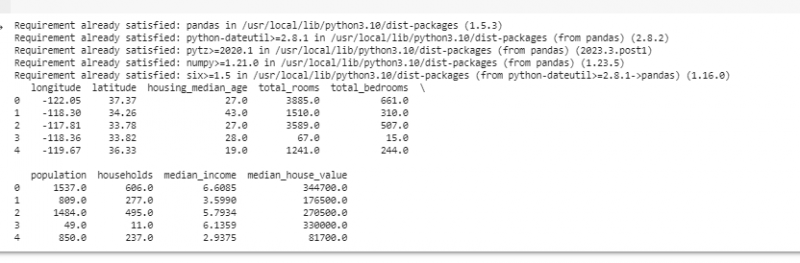

Ora importiamo i Panda e carichiamo i nostri dati di esempio. Per questo esempio, utilizziamo Google Colab per eseguire i codici. Quindi, per prima cosa importiamo i Panda inserendo il seguente comando:

! pip installa panda

importare panda COME pd

importare insensato COME per esempio.

Quindi, carichiamo il set di dati che vogliamo visualizzare utilizzando il metodo pd.read() che accetta il percorso del file come parametro di input.

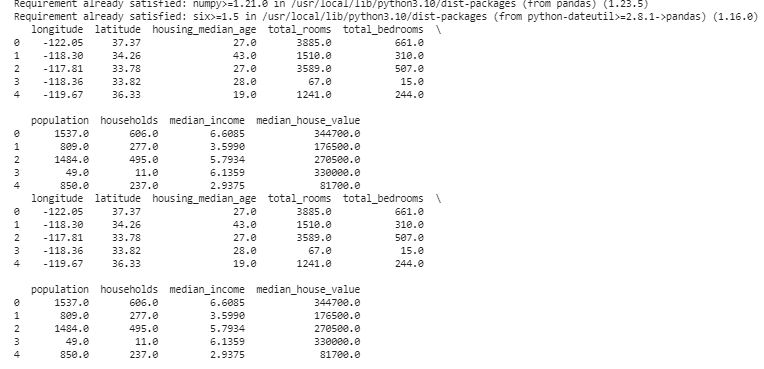

# Carica il set di datidati = pd. leggi_csv ( '/content/sample_data/california_housing_test.csv' )

# Visualizza le prime righe

stampa ( dati. Testa ( ) )

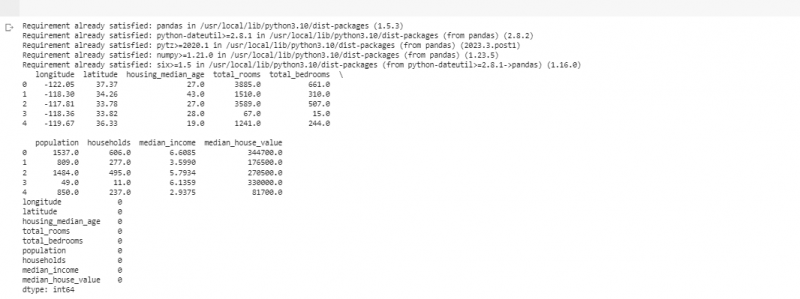

Nel prossimo esempio, utilizziamo i dati sulle vendite in un piccolo negozio. Per gestire i dati mancanti, a volte le informazioni mancano nei nostri dati. Chiamiamo queste parti mancanti “NaN” (che significa “non un numero”). Per trovare questi valori mancanti nello script Python, carichiamo prima il set di dati come abbiamo fatto nell'esempio precedente. Quindi, troviamo eventuali valori mancanti nel set di dati utilizzando la funzione 'missing_values = data.isnull().sum()'. Questa funzione trova tutti i valori mancanti nel set di dati. Quindi li visualizziamo utilizzando la funzione print().

! pip installa pandaimportare panda COME pd

importare insensato COME per esempio.

# Carica il set di dati

dati = pd. leggi_csv ( '/content/sample_data/california_housing_test.csv' )

# Visualizza le prime righe

stampa ( dati. Testa ( ) )

# Controlla i valori mancanti

valori mancanti = dati. è zero ( ) . somma ( )

# Visualizza il conteggio dei valori mancanti per colonna

stampa ( valori mancanti )

Dopo aver trovato eventuali dati mancanti in qualsiasi riga che esegue il codice menzionato in precedenza, possiamo rimuovere quelle righe poiché non contengono molti dati utili. Possiamo anche indovinare i valori mancanti e riempire gli spazi vuoti con ipotesi plausibili stimando i dati basati sul tempo in base ai punti vicini.

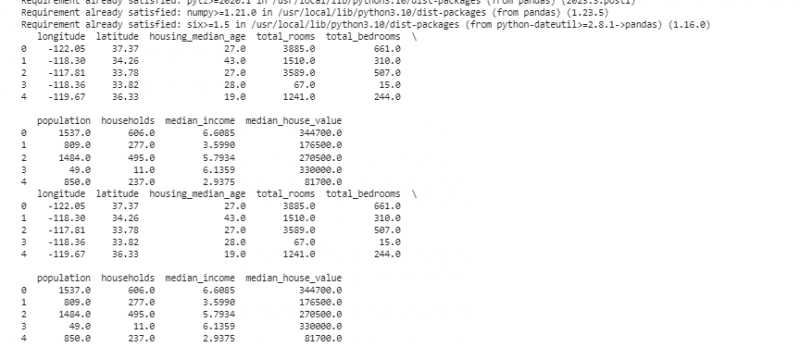

Ora rimuoviamo i duplicati che sono copie della stessa cosa perché possono confondere la nostra analisi. Per trovare i valori duplicati nel set di dati, utilizziamo la funzione “duplicate_rows = data[data.duplicated()]”. Per eliminare questi valori duplicati, chiamiamo la funzione data.drop_duplicates(). Possiamo trovarli e rimuoverli utilizzando il seguente codice:

! pip installa pandaimportare panda COME pd

importare insensato COME per esempio.

# Carica il set di dati

dati = pd. leggi_csv ( '/content/sample_data/california_housing_test.csv' )

# Visualizza le prime righe

stampa ( dati. Testa ( ) )

# Controlla le righe duplicate

righe_duplicate = dati [ dati. duplicato ( ) ]

# Rimuovi i duplicati

dati = dati. drop_duplicates ( )

# Visualizza le prime righe dopo aver rimosso i duplicati

stampa ( dati. Testa ( ) )

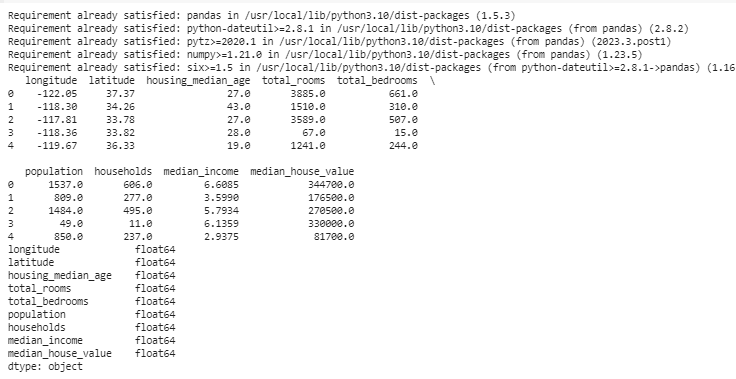

I tipi di dati decidono quali dati possono essere archiviati per correggere i tipi di dati. È essenziale avere il tipo giusto per ogni tipo di dati. Ad esempio, le date dovrebbero avere il tipo di dati data e ora e i numeri dovrebbero essere nel tipo di dati come int, float, ecc. Per verificare i tipi di dati dei nostri dati, utilizziamo la funzione 'data.dtypes'. Questa funzione può essere utilizzata nel modo seguente:

! pip installa pandaimportare panda COME pd

importare insensato COME per esempio.

# Carica il set di dati

dati = pd. leggi_csv ( '/content/sample_data/california_housing_test.csv' )

# Visualizza le prime righe

stampa ( dati. Testa ( ) )

# Controlla i tipi di dati di ciascuna colonna

tipi di dati = dati. dtypes

# Visualizza i tipi di dati

stampa ( tipi di dati )

Se riscontriamo problemi, possiamo modificare il tipo di dati utilizzando Pandas. Ad esempio, possiamo trasformare le date in un formato data. L'attributo 'dtypes' di un DataFrame fornisce informazioni sui tipi di dati di ciascuna colonna. Se scopriamo che il tipo di dati non corrisponde, possiamo utilizzare la funzione astype() di Panda per convertire le colonne nei tipi desiderati.

Dopo i tipi di dati, a volte incontriamo valori anomali che sono valori molto diversi dagli altri. Possono rovinare i nostri calcoli. Per gestire i valori anomali, definiamo una funzione che utilizza la funzione z-score “np.abs(stats.zscore(data))” che confronta i valori presenti nei nostri dati con il valore di soglia. Qualsiasi valore diverso dall'intervallo di questa soglia è considerato un valore anomalo . Vediamo come trovare e gestire gli outlier:

! pip installa pandaimportare panda COME pd

importare insensato COME per esempio.

# Carica il set di dati

dati = pd. leggi_csv ( '/content/sample_data/california_housing_test.csv' )

# Visualizza le prime righe

stampa ( dati. Testa ( ) )

da scipy importare statistiche

def rileva_valori anomali ( dati ) :

z_score = per esempio. addominali ( statistiche. punteggio z ( dati ) )

ritorno per esempio. Dove ( z_score > 3 )

# Rileva e gestisci i valori anomali nella colonna 'Vendite'.

valori anomali = rileva_valori anomali ( dati [ 'longitudine' ] )

dati [ 'longitudine' ] . posto [ valori anomali ] = dati [ 'longitudine' ] . mediano ( )

# Rileva e gestisce i valori anomali nella colonna 'Unità vendute'.

valori anomali = rileva_valori anomali ( dati [ 'latitudine' ] )

dati [ 'latitudine' ] . posto [ valori anomali ] = dati [ 'latitudine' ] . mediano ( )

# Visualizza le prime righe dopo aver gestito i valori anomali

stampa ( dati. Testa ( ) )

Usiamo un metodo semplice per trovare e correggere i valori anomali nel codice precedente. Implica la sostituzione dei valori estremi con il valore medio dei dati. Questo codice utilizza il metodo Z-score per rilevare i valori anomali nelle colonne 'longitudine' e 'latitudine' del nostro set di dati. I valori anomali vengono sostituiti con i valori mediani delle rispettive colonne.

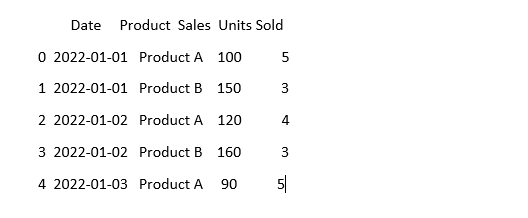

Per far sì che i dati sembrino uguali, a volte i dati possono apparire diversi anche se significano la stessa cosa. Ad esempio, le date possono essere scritte in vari formati. La standardizzazione implica garantire un formato e una rappresentazione dei dati coerenti. Ciò può includere la formattazione delle date, la conversione del testo in minuscolo o la normalizzazione dei valori numerici. Standardizziamo la colonna 'Data' nel nostro set di dati e assicuriamoci che i nostri dati abbiano lo stesso aspetto:

importare panda COME pdimportare insensato COME per esempio. # Importa numpy

# Carica i dati

dati = pd. leggi_csv ( 'dati_vendite.csv' )

# Rendi coerente la colonna 'Data'.

dati [ 'Data' ] = pd. a_dataora ( dati [ 'Data' ] )

# Guarda come appare adesso

stampa ( dati. Testa ( ) )

In questo esempio, standardizziamo il formato della data nel nostro set di dati nel formato datetime di Python utilizzando la funzione 'pd.to_datetime(data['Date'])'. Convertendo la colonna 'Data' nello stesso formato, semplifichiamo il lavoro con questi dati. L'output mostra le prime righe del set di dati con la colonna 'Data' standardizzata.

Conclusione

Nel nostro viaggio attraverso la pulizia dei dati utilizzando Python e Panda, abbiamo imparato come migliorare i nostri dati per l'analisi. Abbiamo iniziato comprendendo perché la pulizia dei dati è così importante. Ci aiuta a prendere decisioni migliori. Abbiamo esplorato come gestire i dati mancanti, rimuovere i duplicati, correggere i tipi di dati, gestire i valori anomali e rendere i nostri dati uguali. Con queste competenze, siamo più preparati a trasformare dati disordinati in qualcosa di cui possiamo fidarci e da utilizzare per scoprire informazioni importanti. La pulizia dei dati è un processo continuo, come tenere in ordine la nostra stanza, e rende il nostro percorso di analisi dei dati più efficace.