Questo post illustra il metodo di utilizzo delle funzioni e delle classi del parser di output tramite il framework LangChain.

Come utilizzare il parser di output tramite LangChain?

I parser di output sono gli output e le classi che possono aiutare a ottenere l'output strutturato dal modello. Per apprendere il processo di utilizzo dei parser di output in LangChain, segui semplicemente i passaggi elencati:

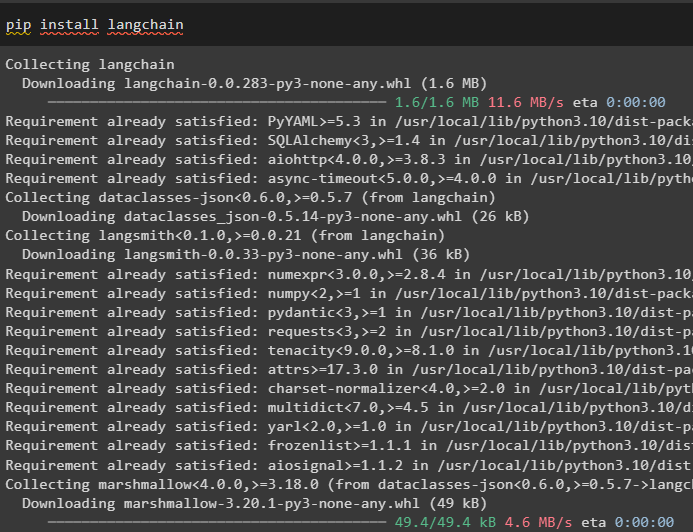

Passaggio 1: installare i moduli

Innanzitutto, avvia il processo di utilizzo dei parser di output installando il modulo LangChain con le sue dipendenze per completare il processo:

pip installare langchain

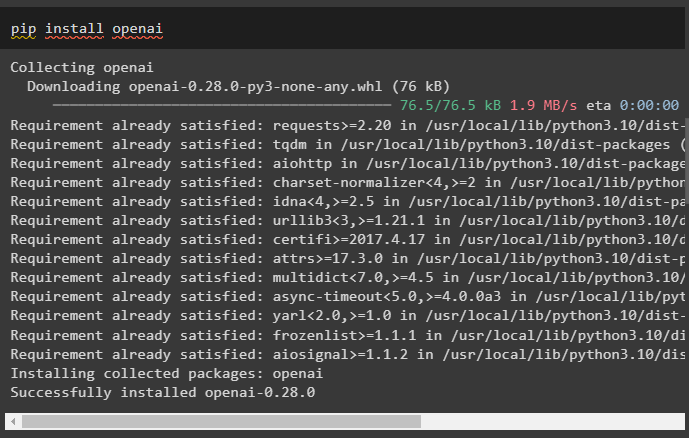

Successivamente, installa il modulo OpenAI per utilizzare le sue librerie come OpenAI e ChatOpenAI:

pip installare openai

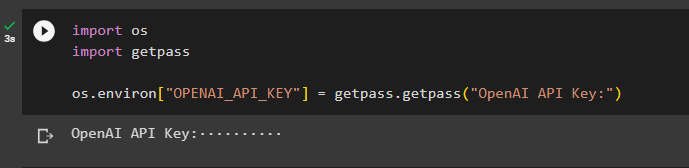

Ora, imposta il ambiente per OpenAI utilizzando la chiave API dall'account OpenAI:

importaci

importa getpass

os.ambiente [ 'OPENAI_API_KEY' ] = getpass.getpass ( 'Chiave API OpenAI:' )

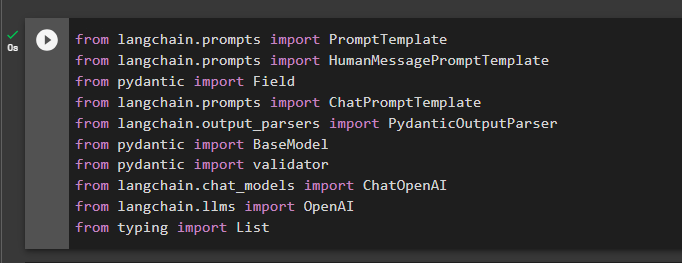

Passaggio 2: importare librerie

Il passo successivo è importare le librerie da LangChain per utilizzare i parser di output nel framework:

da langchain.prompts importa HumanMessagePromptTemplate

dall'importazione pydantic Field

da langchain.prompts importa ChatPromptTemplate

da langchain.output_parsers importa PydanticOutputParser

dall'importazione pydantic BaseModel

dal validatore di importazione pydantic

da langchain.chat_models importa ChatOpenAI

da langchain.llms importa OpenAI

digitando Import List

Passaggio 3: creazione della struttura dei dati

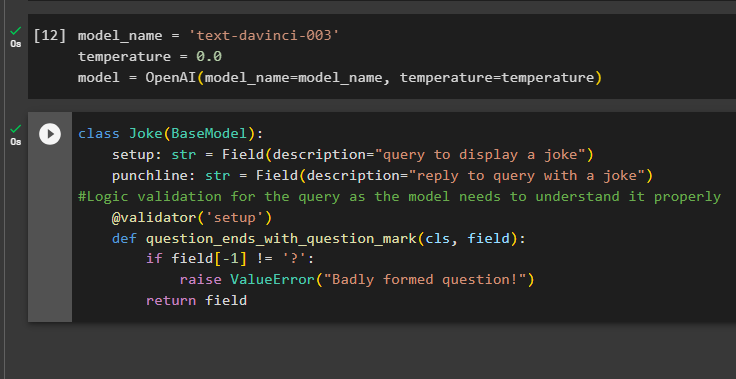

Costruire la struttura dell'output è l'applicazione vitale dei parser di output nei modelli linguistici di grandi dimensioni. Prima di arrivare alla struttura dati dei modelli, è necessario definire il nome del modello che stiamo utilizzando per ottenere l'output strutturato dai parser di output:

temperatura = 0,0

modello = OpenAI ( nome del modello =nome_modello, temperatura =temperatura )

Ora utilizza la classe Joke contenente BaseModel per configurare la struttura dell'output per ottenere la battuta dal modello. Successivamente, l'utente può aggiungere facilmente una logica di convalida personalizzata con la classe pydantic che può chiedere all'utente di inserire una query/prompt meglio strutturata:

Scherzo di classe ( Modello base ) :impostazione: str = Campo ( descrizione = 'query per visualizzare una battuta' )

battuta finale: str = Campo ( descrizione = 'rispondi alla domanda con una battuta' )

#Convalida logica per la query poiché il modello deve comprenderla correttamente

@ validatore ( 'impostare' )

def la domanda_finisce_con_punto_interrogativo ( cls, campo ) :

Se campo [ - 1 ] ! = '?' :

solleva ValueError ( 'Domanda mal formulata!' )

ritorno campo

Passaggio 4: impostazione del modello di richiesta

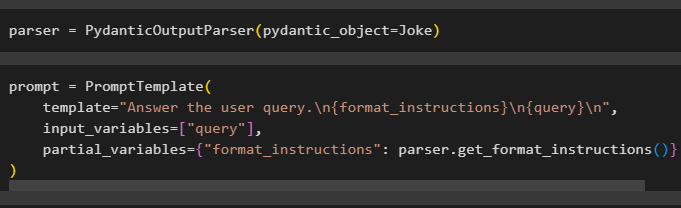

Configura la variabile parser contenente il metodo PydanticOutputParser() contenente i suoi parametri:

Dopo aver configurato il parser è sufficiente definire la variabile prompt utilizzando il metodo PromptTemplate() con la struttura della query/prompt:

prompt = Modello Prompt (modello = 'Rispondi alla domanda dell'utente. \N {formato_istruzioni} \N {query} \N ' ,

input_variabili = [ 'interrogazione' ] ,

variabili_parziali = { 'format_istruzioni' : parser.get_format_instructions ( ) }

)

Passaggio 5: testare il parser di output

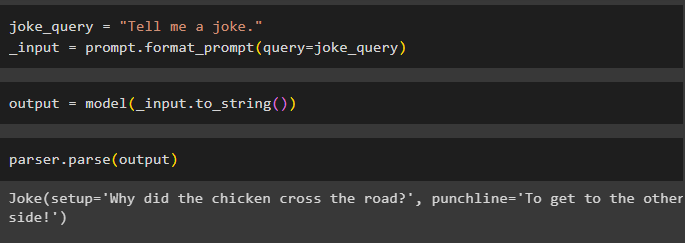

Dopo aver configurato tutti i requisiti, crea una variabile assegnata utilizzando una query e quindi chiama il metodo format_prompt():

_input = prompt.format_prompt ( domanda =scherzo_query )

Ora, chiama la funzione model() per definire la variabile di output:

risultato = modello ( _input.a_stringa ( ) )Completa il processo di test chiamando il metodo parser() con la variabile di output come parametro:

parser.parse ( produzione )

Questo è tutto incentrato sul processo di utilizzo del parser di output in LangChain.

Conclusione

Per utilizzare il parser di output in LangChain, installa i moduli e configura l'ambiente OpenAI utilizzando la sua chiave API. Successivamente definire il modello e quindi configurare la struttura dati dell'output con validazione logica della query fornita dall'utente. Una volta configurata la struttura dei dati, è sufficiente impostare il modello di prompt e quindi testare il parser di output per ottenere il risultato dal modello. Questa guida ha illustrato il processo di utilizzo del parser di output nel framework LangChain.