Questa guida illustrerà il processo di utilizzo del grafico della conoscenza della conversazione in LangChain.

Come utilizzare il grafico della conoscenza della conversazione in LangChain?

IL ConversazioneKGMemory la libreria può essere utilizzata per ricreare la memoria che può essere utilizzata per ottenere il contesto dell'interazione. Per apprendere il processo di utilizzo del grafico della conoscenza della conversazione in LangChain, segui semplicemente i passaggi elencati:

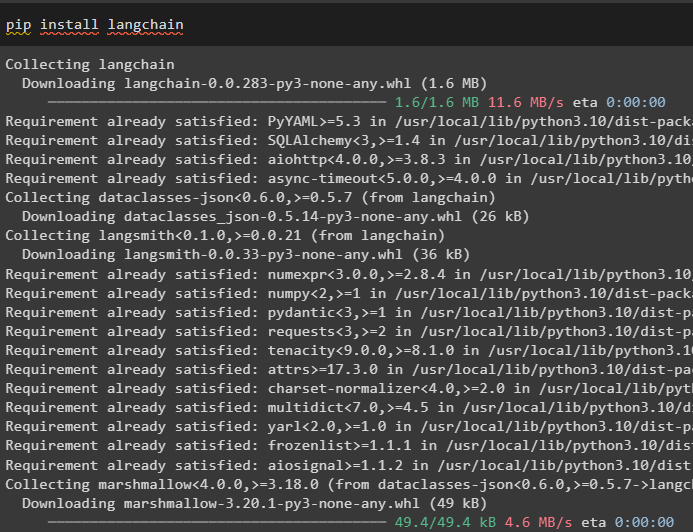

Passaggio 1: installare i moduli

Innanzitutto, inizia con il processo di utilizzo del grafico della conoscenza della conversazione installando il modulo LangChain:

pip installa langchain

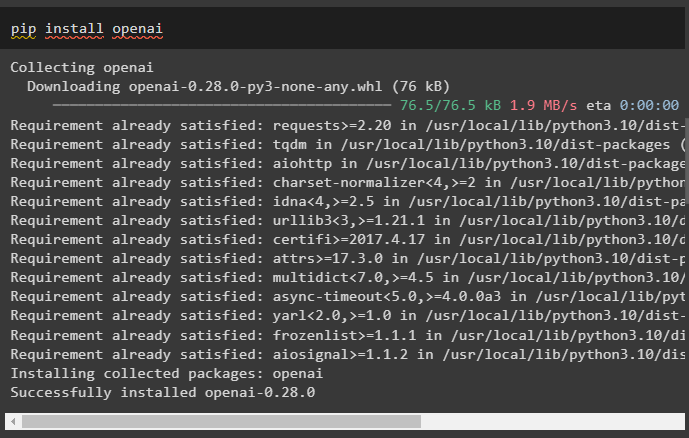

Installa il modulo OpenAI che può essere installato utilizzando il comando pip per ottenere le sue librerie per la creazione di modelli linguistici di grandi dimensioni:

pip installa openai

Ora, impostare l'ambiente utilizzando la chiave API OpenAI che può essere generata dal proprio account:

importare Voi

importare getpass

Voi . circa [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'Chiave API OpenAI:' )

Passaggio 2: utilizzo della memoria con LLM

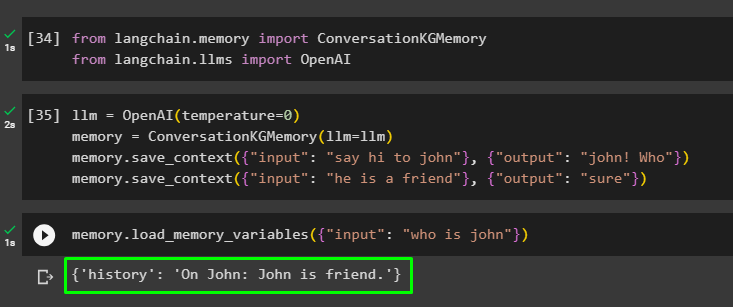

Una volta installati i moduli, inizia a utilizzare la memoria con LLM importando le librerie richieste dal modulo LangChain:

da langchain. memoria importare ConversazioneKGMemoryda langchain. llms importare OpenAI

Costruisci LLM utilizzando il metodo OpenAI() e configura la memoria utilizzando ConversazioneKGMemory () metodo. Successivamente, salva i modelli di prompt utilizzando più input con la rispettiva risposta per addestrare il modello su questi dati:

llm = OpenAI ( temperatura = 0 )memoria = ConversazioneKGMemory ( llm = llm )

memoria. salva_contesto ( { 'ingresso' : 'saluta Giovanni' } , { 'produzione' : 'Giovanni! Chi' } )

memoria. salva_contesto ( { 'ingresso' : 'lui è un amico' } , { 'produzione' : 'Sicuro' } )

Testare la memoria caricando il file variabili_di_memoria () metodo che utilizza la query relativa ai dati di cui sopra:

memoria. carica_variabili_memoria ( { 'ingresso' : 'chi è Giovanni' } )

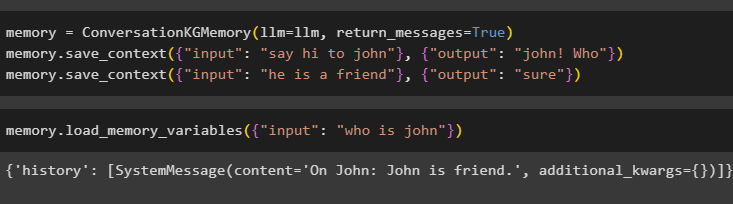

Configura la memoria utilizzando il metodo ConversationKGMemory() con il file return_messages argomento per ottenere anche la cronologia dell'input:

memoria = ConversazioneKGMemory ( llm = llm , return_messages = VERO )memoria. salva_contesto ( { 'ingresso' : 'saluta Giovanni' } , { 'produzione' : 'Giovanni! Chi' } )

memoria. salva_contesto ( { 'ingresso' : 'lui è un amico' } , { 'produzione' : 'Sicuro' } )

Testa semplicemente la memoria fornendo all'argomento di input il suo valore sotto forma di query:

memoria. carica_variabili_memoria ( { 'ingresso' : 'chi è Giovanni' } )

Ora, testa la memoria ponendo la domanda che non è menzionata nei dati di addestramento e il modello non ha idea della risposta:

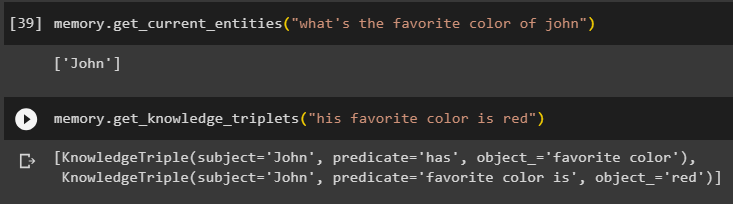

memoria. get_current_entities ( 'qual è il colore preferito di John' )Usa il get_knowledge_triplets () rispondendo alla domanda posta in precedenza:

memoria. get_knowledge_triplets ( 'il suo colore preferito è il rosso' )

Passaggio 3: utilizzo della memoria in catena

Il passaggio successivo utilizza la memoria di conversazione con le catene per costruire il modello LLM utilizzando il metodo OpenAI(). Successivamente, configura il modello di prompt utilizzando la struttura della conversazione e il testo verrà visualizzato mentre ottieni l'output dal modello:

llm = OpenAI ( temperatura = 0 )da langchain. richiede . richiesta importare Modello Prompt

da langchain. Catene importare Catena di conversazione

modello = '''Questo è il modello per l'interazione tra uomo e macchina

Il sistema è un modello di intelligenza artificiale in grado di parlare o estrarre informazioni su molteplici aspetti

Se non capisce la domanda o non ha la risposta, lo dice semplicemente

Il sistema estrae i dati memorizzati nella sezione 'Specifico' e non ha allucinazioni

Specifica:

{storia}

Conversazione:

Umano: {input}

AI:'''

#Configurare il modello o la struttura per fornire suggerimenti e ottenere risposta dal sistema AI

richiesta = Modello Prompt ( input_variabili = [ 'storia' , 'ingresso' ] , modello = modello )

conversazione_con_kg = Catena di conversazioni (

llm = llm , prolisso = VERO , richiesta = richiesta , memoria = ConversazioneKGMemory ( llm = llm )

)

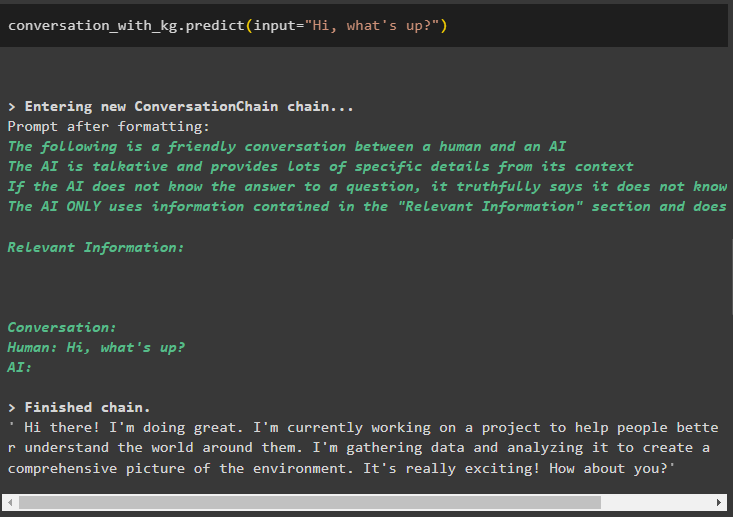

Una volta creato il modello, chiama semplicemente il file conversazione_con_kg modello utilizzando il metodo predit() con la query posta dall'utente:

conversazione_con_kg. prevedere ( ingresso = 'Ciao come va?' )

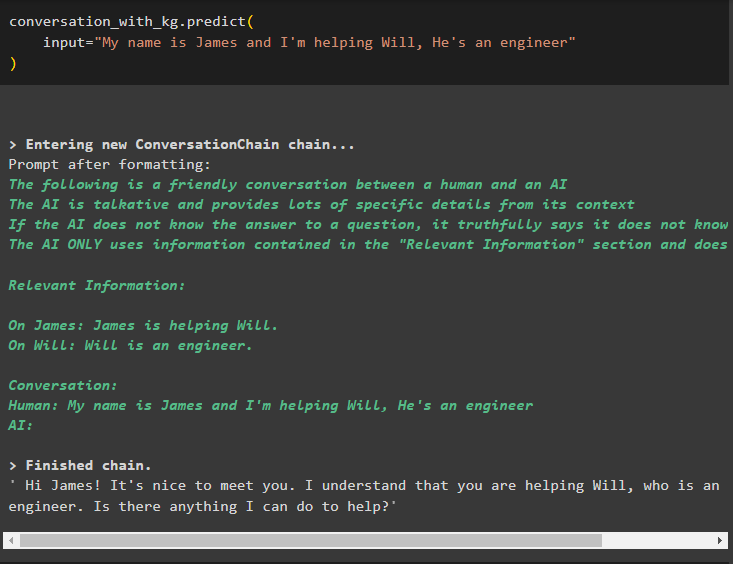

Ora addestra il modello utilizzando la memoria di conversazione fornendo le informazioni come argomento di input per il metodo:

conversazione_con_kg. prevedere (ingresso = 'Mi chiamo James e sto aiutando Will, è un ingegnere'

)

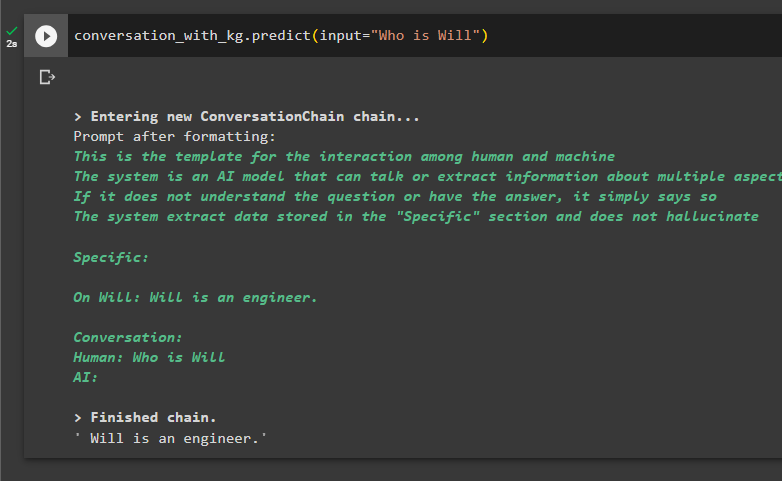

Ecco il momento di testare il modello chiedendo alle query di estrarre informazioni dai dati:

conversazione_con_kg. prevedere ( ingresso = 'Chi è Will' )

Tutto ciò riguarda l'utilizzo del grafico della conoscenza della conversazione in LangChain.

Conclusione

Per utilizzare il grafico della conoscenza della conversazione in LangChain, installa i moduli o i framework per importare le librerie per utilizzare il metodo ConversationKGMemory(). Successivamente, crea il modello utilizzando la memoria per costruire le catene ed estrarre informazioni dai dati di training forniti nella configurazione. Questa guida ha elaborato il processo di utilizzo del grafico della conoscenza della conversazione in LangChain.