In questo articolo, discuteremo delle policy di rete in Kubernetes. Le policy di rete sono molto importanti in Kubernetes. Con l'aiuto delle policy di rete, specifichiamo come i pod comunicano tra loro e come creiamo le connessioni tra i pod. Se sei nuovo a questo concetto, questo articolo fa per te. Iniziamo l'articolo con una definizione dettagliata delle policy di rete in Kubernetes.

Cosa sono i criteri di rete in Kubernetes?

Una policy di rete in Kubernetes descrive in che modo i gruppi di pod possono comunicare tra loro e con altri endpoint di rete. La risorsa Criteri di rete, che specifica come i pod possono comunicare, viene utilizzata per implementare i criteri di rete. Puoi proteggere il tuo cluster e gestire il flusso del traffico all'interno e tra i tuoi pod specificando un controllo granulare dell'accesso alla rete per il tuo cluster utilizzando i criteri di rete.

Prerequisiti:

Il sistema utilizzato dall'utente deve essere un sistema operativo a 64 bit. La RAM dell'utente deve essere di almeno 8 GB o superiore a 8 GB. L'ultima versione di Ubuntu è installata nel sistema dell'utente. L'utente Windows utilizza anche il sistema operativo Linux virtualmente sul proprio sistema. L'utente deve avere un'idea di Kubernetes, dello strumento a riga di comando kubectl, dei pod e del cluster eseguito nel nostro sistema nella sessione precedente.

Passaggio 1: avvia un pannello di controllo Kubernetes

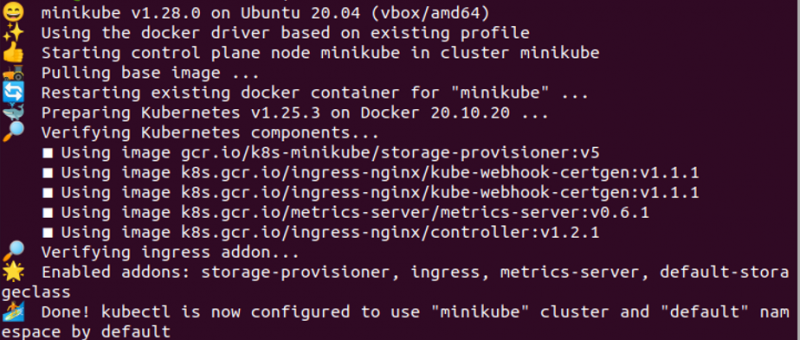

In questa fase, eseguiamo Kubernetes nel nostro sistema per avviare perfettamente il funzionamento delle nostre policy di rete. Avviamo minikube nel nostro sistema semplicemente eseguendo il comando. Minikube è un cluster Kubernetes che viene eseguito sulla macchina locale. Il comando per avviare minikube è:

> avviare minikube

Quando il comando viene eseguito, minikube si avvia correttamente nel nostro sistema. Ora possiamo eseguire facilmente le nostre azioni relative ai criteri di rete in modo efficiente nel nostro sistema.

Passaggio 2: crea un deployment Nginx in Kubernetes

In questa fase, impariamo come creare una distribuzione di Nginx nel nostro sistema Kubernetes. Eseguiamo il comando dato nello strumento da riga di comando kubectl. Il comando è:

> kubectl crea esempio di distribuzione - - image = nginx

All'esecuzione del comando, la distribuzione viene creata correttamente nella cartella dell'app nella nostra applicazione Kubernetes. L'immagine Nginx viene distribuita correttamente nel nostro sistema. La distribuzione garantirà che il numero specificato di repliche del pod sia sempre in esecuzione, creando o eliminando le repliche secondo necessità. Ci consentirà inoltre di aggiornare perfettamente le immagini dei container in un aggiornamento progressivo nel nostro sistema Kubernetes.

Passaggio 3: distribuzione di esempio su una porta specifica in Kubernetes

In questo passaggio, esporremo ora l'esempio che sta recentemente tentando di distribuire sul sistema su una porta specifica. Eseguiremo il comando:

> kubectl espone l'esempio di distribuzione - - port = 80

Quando il comando viene eseguito, il campione di distribuzione viene esposto correttamente sulla porta 80 nella nostra applicazione Kubernetes. Il server API Kubernetes riceverà una richiesta da questo comando per creare il servizio. Il server API creerà quindi il servizio nel cluster. Ha un indirizzo IP stabile e un nome DNS. Il servizio funge da bilanciamento del carico per i pod nella distribuzione, distribuendo uniformemente il traffico in entrata tra di essi. Questo comando ci fornisce un endpoint di rete stabile per i pod, consentendo loro di accedervi anche se i loro indirizzi IP vengono sostituiti.

Passaggio 4: arruola il pod dei servizi in Kubernetes

Dopo la distribuzione dell'esempio nel sistema, otterremo l'elenco dei servizi in esecuzione in Kubernetes. Per recuperare informazioni su tutti i pod nel cluster, eseguiamo il comando:

> kubectl ottieni svc, pod

Quando abbiamo eseguito il comando, l'elenco dei servizi viene visualizzato sull'output. L'esempio nei servizi è mostrato nell'elenco. Il nome, il tipo, l'IP del cliente, l'IP esterno, le PORTE e l'età dei pod e dei servizi vengono visualizzati perfettamente tramite questo comando. Il 'servizio/campione' ha il numero di porta '80', l'IP del cluster è '10.105.250.227'.

Passaggio 5: crea il criterio di rete Ngnix in Kubernetes

In questo passaggio, creeremo un file Nginx attraverso il quale creeremo una policy di rete nella nostra applicazione Kubernetes. Creeremo un criterio di rete e quindi distribuiremo facilmente un criterio di rete in Kubernetes con l'aiuto del comando kubectl. Il comando è:

> kubectl si applica -f https: // k8s.io / esempi / servizio / rete / ngnix-policy.yaml

Nel comando, aggiungiamo un collegamento al file di policy networking e diamo il nome del file 'Nginx-policy'. L'estensione del file dei criteri di rete è 'YAML'. Quando questo comando viene eseguito, la cartella dei criteri di rete esiste già nel nostro sistema in cui il file YAML access-ngnix viene creato correttamente. Il file di configurazione che viene applicato con questo comando è per l'oggetto servizio Kubernetes, che espone una serie di pod come servizi di rete.

Passaggio 6: crea ed esegui un nuovo pod in Kubernetes

In questa fase creeremo un nuovo pod in un cluster Kubernetes. Questo pod eseguirà un contenitore basato su busybox:1.28 e avrà un'immagine docker. Eseguiremo il comando '/bin/sh' sullo strumento della riga di comando kubectl.

> kubectl esegue busybox - - rm - ti - - image = busybox : uno . 28 - - / bidone / sh

Il comando 'kubectl run' crea una distribuzione nel cluster, che è responsabile della gestione di un set di repliche del pod. Un set di replica e un pod verranno creati automaticamente dalla distribuzione per il contenitore.

Conclusione

Con l'aiuto della policy di rete, possiamo facilmente creare connessioni tra diversi pod e container. Puoi anche modificare questi comandi in base ai requisiti dell'applicazione Kubernetes che ti aiuteranno a comprendere meglio questo argomento. Il collegamento in rete di tutti i pod è molto importante e vantaggioso per i metadati dei pod.