Sintassi:

Poiché conosciamo ChatGPT, sappiamo che questa piattaforma è di proprietà della comunità Open AI e fornisce strumenti, architetture, API e diversi framework che possiamo utilizzare nella distribuzione delle nostre applicazioni e nei modelli di elaborazione del linguaggio naturale. Open AI offre le API attraverso le quali possiamo utilizzare qualsiasi modello AI e NLP pre-addestrato dalla piattaforma Open AI e possiamo farli funzionare per le nostre applicazioni come, ad esempio, per fornire previsioni su dati in tempo reale. Allo stesso modo, GPT4All consente inoltre ai suoi utenti di integrare i suoi modelli di intelligenza artificiale pre-addestrati con diverse applicazioni.

Il modello GPT4All viene addestrato su dati limitati rispetto a ChatGPT. Ha anche alcuni dei suoi vincoli di prestazioni rispetto a ChatGPT, ma consente all'utente di utilizzare il proprio GPT privato sul proprio hardware locale e non richiede alcuna connessione di rete. Con l'aiuto di questo articolo, scopriremo come utilizzare i modelli GPT4All nello script Python poiché GPT4All ha i collegamenti ufficiali con Python, il che significa che possiamo utilizzare e integrare i modelli GPT4All anche tramite lo script Python.

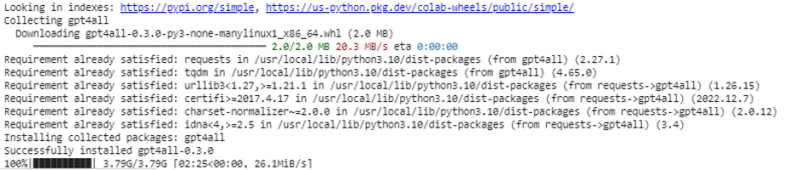

Tutto richiede un comando online per installare GPT4All per l'IDE Python. Quindi, potremmo integrare tanti modelli di intelligenza artificiale quante sono le nostre applicazioni. Il comando per installare questo GPT4All in Python è come mostrato di seguito:

$ pip installa gpt4all

Esempio 1:

Per iniziare con questo esempio, dobbiamo scaricare e installare Python nei nostri sistemi. Le versioni consigliate di Python sono la 'versione 3.7' o quelle successive a questa versione. Un altro modo per lavorare con Python per evitare il lungo processo di installazione della 'configurazione Python' sui nostri sistemi è utilizzare 'Google Colab' che è un ambiente basato su cloud per Python. Possiamo eseguire questo ambiente su qualsiasi browser Web e creare modelli di intelligenza artificiale e machine learning. Gli esempi che implementeremo qui vengono eseguiti in Google Colab.

Questo esempio copre il metodo per installare GPT4All in Python e come usare i suoi modelli pre-addestrati. Iniziamo installando prima GPT4All. Per questo, viene eseguito il comando che abbiamo menzionato in precedenza. Con l'esecuzione del comando, GPT4All insieme ai suoi pacchetti e framework vengono scaricati e installati.

Ora andiamo avanti. Da GPT4All, importiamo 'GPT4All'. Questo aggiunge tutti i modelli preaddestrati da GPT4All al progetto. Ora, possiamo utilizzare qualsiasi singolo modello e fargli fare le previsioni per la nostra applicazione. Una volta importato il pacchetto GPT4All, è giunto il momento di chiamare questa funzione e utilizzare il modello GPT4All che fornisce l'output per il 'completamento della chat'.

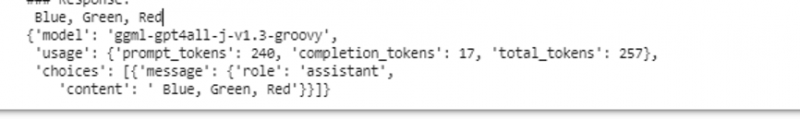

In altre parole, se chiediamo qualcosa a quel modello nell'input, lo restituisce nell'output. Il modello che usiamo qui è 'ggml-gpt4all-j-v1.3-groovy'. Questi modelli sono già archiviati nella cache GPT4All. Possiamo ottenere questi modelli da questo link ' https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” per il download manuale. Se il modello è già presente nella cache GPT4All, chiamiamo semplicemente il nome del modello e lo specifichiamo come parametri di input alla funzione 'GPT4All()'. Se lo abbiamo scaricato manualmente con successo, passiamo il percorso alla cartella in cui si trova il modello. Poiché questo modello è per il completamento del messaggio, la sintassi per questo modello è data come segue:

$ Chat_completamento (messaggi)I messaggi sono un elenco di dizionari e ogni dizionario dovrebbe contenere una chiave di 'ruolo' con un valore dell'utente, del sistema o dell'assistente e il contenuto della 'chiave' che ha il valore come stringa. In questo esempio, specifichiamo il contenuto come 'nome tre colori' e la chiave del ruolo come 'utente'.

$modello= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messaggi = [{'role': 'utente', 'content': 'Nomina 3 fiori'}]

Dopo questa specifica, chiamiamo la funzione 'chat_completion()' con il modello. Il codice per questo viene visualizzato nel seguente output:

$ !pip installa gpt4allda gpt4all importa GPT4All

modello = GPT4All('ggml-gpt4all-j-v1.3-groovy')

messaggi = [{'role': 'user', 'content': 'Nome tre colori'}]

model.chat_completion(messaggi)

Dopo l'esecuzione di questo esempio, il modello restituisce tre colori come risposta all'input.

Esempio 2:

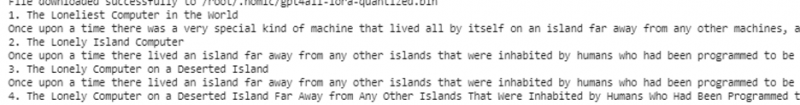

Copriamo un altro esempio in cui scopriamo un altro metodo per utilizzare GPT4All in Python. Questo può essere fatto utilizzando i collegamenti ufficiali per Python forniti da 'Nomic', che è una comunità AI open source e gestisce GPT4All. Usando il seguente comando, integriamo 'nomic' nella nostra console Python:

$ pip installa nomicUna volta installato, importiamo GPT4All da 'nomic.gpt4all'. Dopo aver importato GPT4All, inizializziamo GPT4All con la funzione 'open()'. Quindi, chiamiamo la funzione 'prompt ()' e passiamo un prompt a questa funzione. Quindi, viene generata una risposta al prompt in base al prompt che abbiamo fornito come input al modello di prompt.

!pip install nomicda nomic.gpt4all importa GPT4All

# Inizializza il modello GPT4All

inizia = GPT4All()

inizia.apri()

# Generazione di una risposta basata sul prompt

model_response = initial.prompt('scrivi una breve storia su un computer)

# visualizzazione della risposta generata

print(modello_risposta)

L'output mostra la risposta rapida dal modello che abbiamo generato utilizzando il modello GPT4All preaddestrato in Python. Se vogliamo saperne di più sui modelli e su come possiamo utilizzare questi modelli per generare le risposte, o in parole semplici, se vogliamo acquisire conoscenze sulla sintassi per generare le risposte da questi modelli, possiamo ricevere ulteriore aiuto dal GPT4Tutti i dettagli della documentazione tecnica.

Conclusione

GPT4All sta ancora cercando di ottenere l'accuratezza delle prestazioni. È gestito dalla piattaforma Nomic AI che mira a fornire chatbot artificialmente intelligenti ai suoi utenti sulle CPU di livello consumer poiché GPT4All funziona senza alcuna connessione di rete e GPU. Questo articolo ci illumina sull'uso proficuo di PyGPT4All in un ambiente Python e sulla creazione di un'interazione tra le nostre applicazioni e i modelli AI GPT4All pre-addestrati. In questa guida abbiamo coperto due diversi metodi su come installare GPT4All in Python.